资料内容:

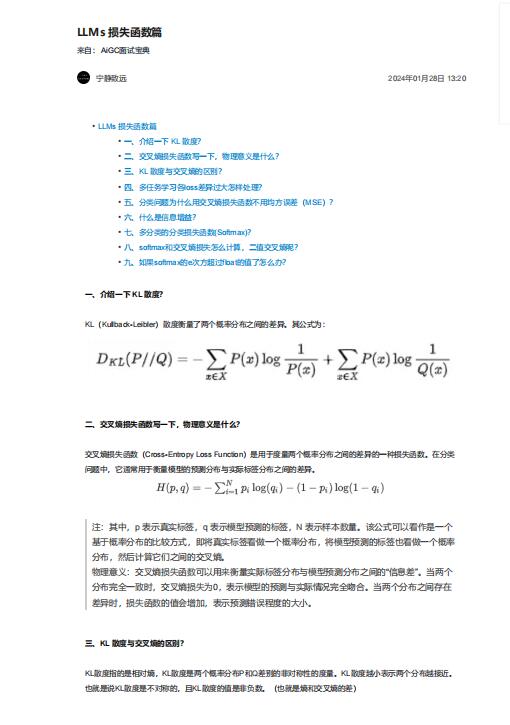

三、KL 散度与交叉熵的区别?

KL散度指的是相对熵,KL散度是两个概率分布P和Q差别的非对称性的度量。KL散度越小表示两个分布越接近。

也就是说KL散度是不对称的,且KL散度的值是非负数。(也就是熵和交叉熵的差)

• 交叉熵损失函数是二分类问题中最常用的损失函数,由于其定义出于信息学的角度,可以泛化到多分类问题

中。

• KL散度是一种用于衡量两个分布之间差异的指标,交叉熵损失函数是KL散度的一种特殊形式。在二分类问题

中,交叉熵函数只有一项,而在多分类问题中有多项。

四、多任务学习各loss差异过大怎样处理?

多任务学习中,如果各任务的损失差异过大,可以通过动态调整损失权重、使用任务特定的损失函数、改变模型

架构或引入正则化等方法来处理。目标是平衡各任务的贡献,以便更好地训练模型