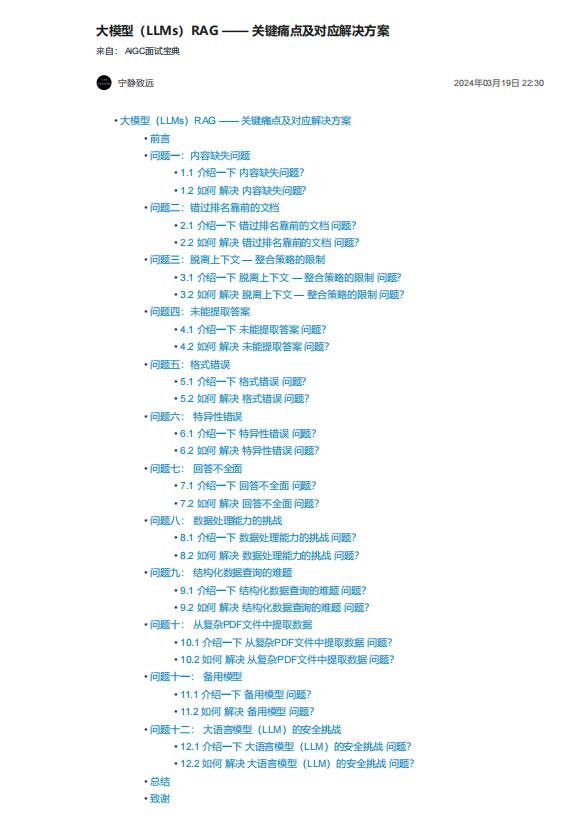

资料内容:

前言

受到 Barnett 等人的论文《Seven Failure Points When Engineering a Retrieval Augmented

Generation System》的启发,本文将探讨论文中提到的七个痛点,以及在开发检索增强型生成

(RAG)流程中常见的五个额外痛点。更为关键的是,我们将深入讨论这些 RAG 痛点的解决策

略,使我们在日常 RAG 开发中能更好地应对这些挑战。

问题一:内容缺失问题

1.1 介绍一下 内容缺失问题?

当实际答案不在知识库中时,RAG 系统往往给出一个貌似合理却错误的答案,而不是承认无法给

出答案。这导致用户接收到误导性信息,造成错误的引导。

1.2 如何 解决 内容缺失问题?

“输入什么,输出什么。”如果源数据质量差,比如充斥着冲突信息,那么无论你如何构建 RAG 流

程,都不可能从杂乱无章的数据中得到有价值的结果。

2. 改进提示方式

在知识库缺乏信息,系统可能给出错误答案的情况下,改进提示方式可以起到显著帮助。

例如,通过设置提示“如果你无法确定答案,请表明你不知道”

可以鼓励模型认识到自己的局限并更透明地表达不确定性。虽然无法保证百分百准确,但在优化数

据源之后,改进提示方式是我们能做的最好努力之一。

问题二:错过排名靠前的文档

2.1 介绍一下 错过排名靠前的文档 问题?

有时候系统在检索资料时,最关键的文件可能并没有出现在返回结果的最前面。这就导致了正确答

案被忽略,系统因此无法给出精准的回答。

即:“问题的答案其实在某个文档里面,只是它没有获得足够高的排名以致于没能呈现给用户”

2.2 如何 解决 错过排名靠前的文档 问题?

在将检索到的结果发送给大型语言模型(LLM)之前,对结果进行重新排名可以显著提升RAG的性

能。LlamaIndex的一个笔记本展示了两种不同方法的效果对比: