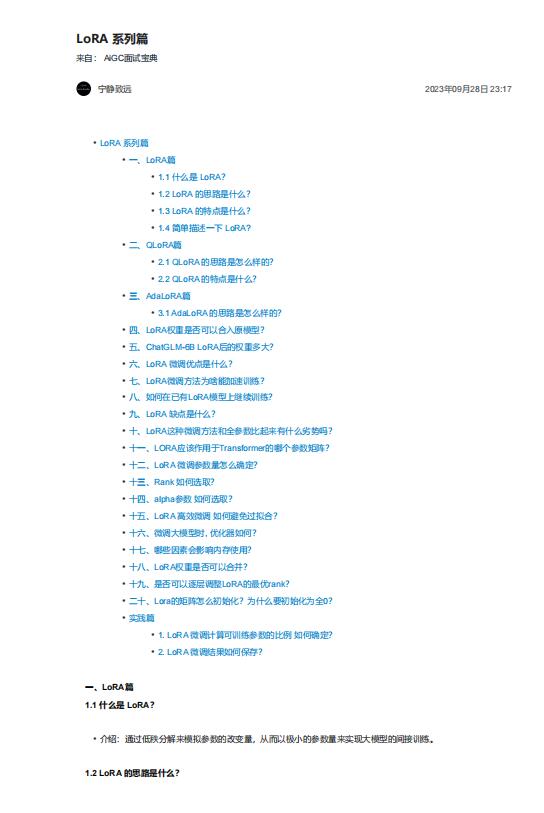

资料内容:

一、LoRA篇

1.1 什么是 LoRA?

• 介绍:通过低秩分解来模拟参数的改变量,从而以极小的参数量来实现大模型的间接训练。

1.2 LoRA 的思路是什么?

1. 在原模型旁边增加一个旁路,通过低秩分解(先降维再升维)来模拟参数的更新量;

2. 训练时,原模型固定,只训练降维矩阵A和升维矩阵B;

3. 推理时,可将BA加到原参数上,不引入额外的推理延迟;

4. 初始化,A采用高斯分布初始化,B初始化为全0,保证训练开始时旁路为0矩阵;

5. 可插拔式的切换任务,当前任务W0+B1A1,将lora部分减掉,换成B2A2,即可实现任务切换;

1.3 LoRA 的特点是什么?

• 将BA加到W上可以消除推理延迟;

• 可以通过可插拔的形式切换到不同的任务;

• 设计的比较好,简单且效果好;

1.4 简单描述一下 LoRA?

LoRA的实现思想很简单,就是冻结一个预训练模型的矩阵参数,并选择用A和B矩阵来替代,在下游任务时只更

新A和B。