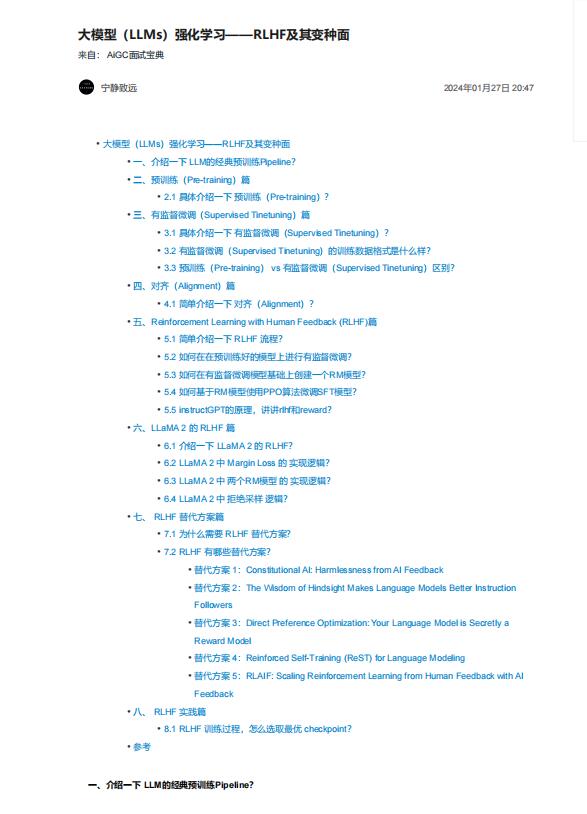

资料内容:

一、介绍一下 LLM的经典预训练Pipeline?

目前基于Transformer decoder的LLM,比如ChatGPT、LLaMA、baichuan等,通常都会有基于预训练的base模

型和在base模型至少使用RLHF微调的Chat模型,Chat模型的训练一般都包括如下三个步骤:预训练,有监督微

调和对齐。

1. 在预训练阶段,模型会从大量无标注文本数据集中学习通用知识;

2. 使用「有监督微调」(SFT)优化模型以更好地遵守特定指令;

3. 使用对齐技术使LLM可以更有用且更安全地响应用户提示。

二、预训练(Pre-training)篇

2.1 具体介绍一下 预训练(Pre-training)?

预训练(Pre-training):利用数十亿到数万亿个token的庞大文本语料库 对模型继续 预训练,使 模型 能够 根据

提供的文本来预测「下一个单词」。

三、有监督微调(Supervised Tinetuning)篇

3.1 具体介绍一下 有监督微调(Supervised Tinetuning)?

有监督微调(Supervised Tinetuning):虽然 SFT 训练目标和 预训练(Pre-training)类似,也是 需要模型 预测

「下一个单词」,但是需要人工标注的指令数据集,其中模型的输入是一个指令(根据任务的不同,也可能包含

一段输入文本),输出为模型的预期回复内容