资料内容:

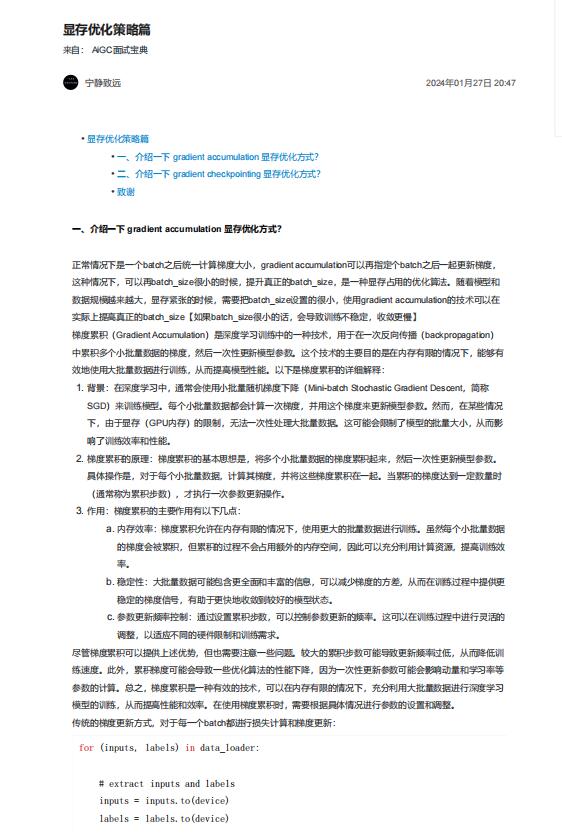

一、介绍一下 gradient accumulation 显存优化方式?

正常情况下是一个batch之后统一计算梯度大小,gradient accumulation可以再指定个batch之后一起更新梯度,

这种情况下,可以再batch_size很小的时候,提升真正的batch_size,是一种显存占用的优化算法。随着模型和

数据规模越来越大,显存紧张的时候,需要把batch_size设置的很小,使用gradient accumulation的技术可以在

实际上提高真正的batch_size【如果batch_size很小的话,会导致训练不稳定,收敛更慢】

梯度累积(Gradient Accumulation)是深度学习训练中的一种技术,用于在一次反向传播(backpropagation)

中累积多个小批量数据的梯度,然后一次性更新模型参数。这个技术的主要目的是在内存有限的情况下,能够有

效地使用大批量数据进行训练,从而提高模型性能。以下是梯度累积的详细解释:

尽管梯度累积可以提供上述优势,但也需要注意一些问题。较大的累积步数可能导致更新频率过低,从而降低训

练速度。此外,累积梯度可能会导致一些优化算法的性能下降,因为一次性更新参数可能会影响动量和学习率等

参数的计算。总之,梯度累积是一种有效的技术,可以在内存有限的情况下,充分利用大批量数据进行深度学习

模型的训练,从而提高性能和效率。在使用梯度累积时,需要根据具体情况进行参数的设置和调整。

传统的梯度更新方式,对于每一个batch都进行损失计算和梯度更新:

1. 背景:在深度学习中,通常会使用小批量随机梯度下降(Mini-batch Stochastic Gradient Descent,简称

SGD)来训练模型。每个小批量数据都会计算一次梯度,并用这个梯度来更新模型参数。然而,在某些情况

下,由于显存(GPU内存)的限制,无法一次性处理大批量数据。这可能会限制了模型的批量大小,从而影

响了训练效率和性能。

2. 梯度累积的原理:梯度累积的基本思想是,将多个小批量数据的梯度累积起来,然后一次性更新模型参数。

具体操作是,对于每个小批量数据,计算其梯度,并将这些梯度累积在一起。当累积的梯度达到一定数量时

(通常称为累积步数),才执行一次参数更新操作。

3. 作用:梯度累积的主要作用有以下几点:

a. 内存效率:梯度累积允许在内存有限的情况下,使用更大的批量数据进行训练。虽然每个小批量数据

的梯度会被累积,但累积的过程不会占用额外的内存空间,因此可以充分利用计算资源,提高训练效

率。

b. 稳定性:大批量数据可能包含更全面和丰富的信息,可以减少梯度的方差,从而在训练过程中提供更

稳定的梯度信号,有助于更快地收敛到较好的模型状态。

c. 参数更新频率控制:通过设置累积步数,可以控制参数更新的频率。这可以在训练过程中进行灵活的

调整,以适应不同的硬件限制和训练需求