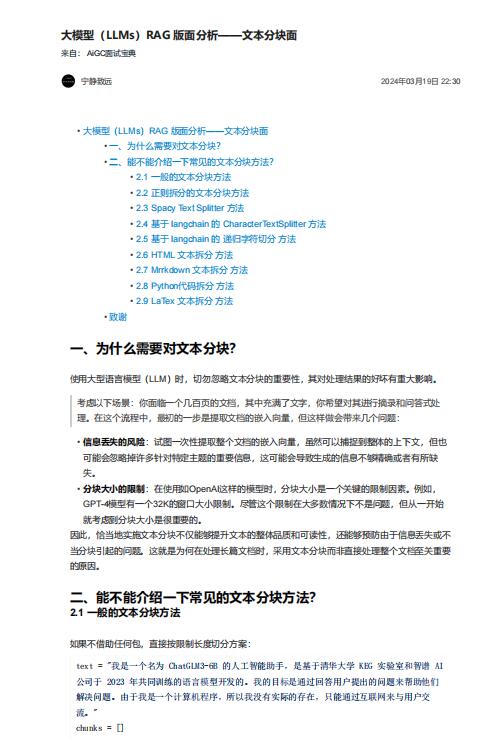

资料内容:

一、为什么需要对文本分块?

使用大型语言模型(LLM)时,切勿忽略文本分块的重要性,其对处理结果的好坏有重大影响。

考虑以下场景:你面临一个几百页的文档,其中充满了文字,你希望对其进行摘录和问答式处

理。在这个流程中,最初的一步是提取文档的嵌入向量,但这样做会带来几个问题:

• 信息丢失的风险:试图一次性提取整个文档的嵌入向量,虽然可以捕捉到整体的上下文,但也

可能会忽略掉许多针对特定主题的重要信息,这可能会导致生成的信息不够精确或者有所缺

失。

• 分块大小的限制:在使用如OpenAI这样的模型时,分块大小是一个关键的限制因素。例如,

GPT-4模型有一个32K的窗口大小限制。尽管这个限制在大多数情况下不是问题,但从一开始

就考虑到分块大小是很重要的。

因此,恰当地实施文本分块不仅能够提升文本的整体品质和可读性,还能够预防由于信息丢失或不

当分块引起的问题。这就是为何在处理长篇文档时,采用文本分块而非直接处理整个文档至关重要

的原因。