资料内容:

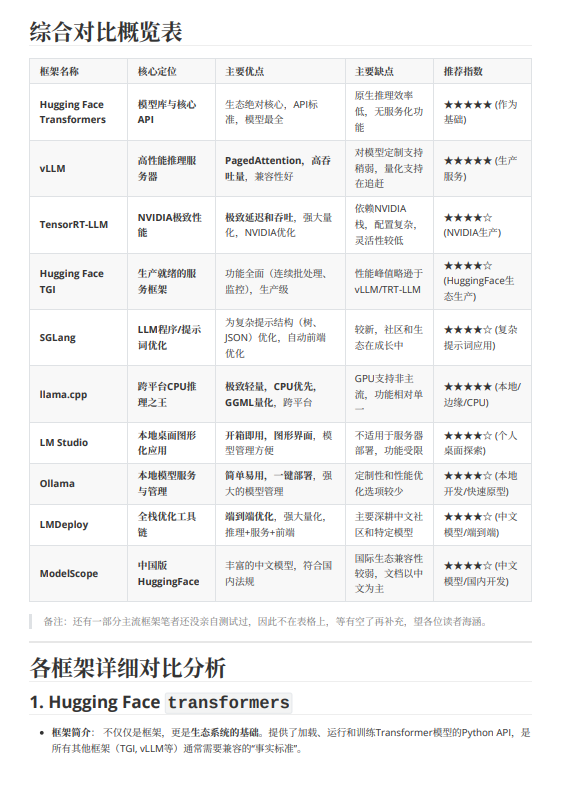

各框架详细对⽐分析

1. Hugging Face transformers

框架简介: 不仅仅是框架,更是⽣态系统的基础。提供了加载、运⾏和训练Transformer模型的Python API,是

所有其他框架(TGI, vLLM等)通常需要兼容的“事实标准”。框架优点:

模型库最全: ⽀持数以万计的预训练模型,是模型分发的中⼼。

API标准: 其 AutoModel 、 AutoTokenizer 等API已成为⾏业标准。

灵活性极⾼: ⽅便⽤于研究、实验和模型微调。

框架缺点:

原⽣推理效率低: 其 pipeline 或 model.generate 接⼝本⾝未做深度优化,吞吐量低。

⽆⽣产级服务功能: 需要⾃⾏构建Web服务器、批处理、监控等。

框架适⽤场景: 模型实验、原型验证、微调训练。是所有应⽤的起点。

框架经典⽤途: 在Jupyter Notebook中快速测试⼀个新模型的效果。

框架成熟度: 极⾼,是⽣态的基⽯。

2. vLLM

框架简介: 由加州伯克利⼤学团队开发的⾼吞吐、易⽤的⼤模型推理和服务引擎。核⼼创新是

PagedAttention。

框架优点:

⾼吞吐量: PagedAttention极⼤减少了KV Cache的内存浪费,在批处理场景下性能卓越。

易⽤性好: 安装部署相对简单,与HuggingFace模型完美兼容。

持续活跃: 开发⾮常活跃,不断加⼊新模型和特性(如量化⽀持)。

框架缺点:

早期对模型的⼀些特殊⽤法(如修改注意⼒机制)⽀持不够灵活,但现在已⼤幅改善。

框架适⽤场景: ⾼并发在线服务、批量⽂本⽣成任务。

框架经典⽤途: 为多个⽤⼾提供并发的ChatGPT式API服务。

框架成熟度: ⾮常⾼,被众多公司⽤于⽣产环境。